Historique du Web et d'Internet

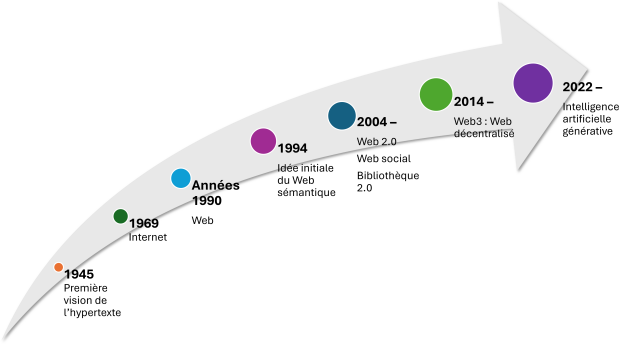

Dans sa conceptualisation, l'histoire de l'Internet et du Web remonte aux années 40 lorsque Vannevar Bush a rêvé d'un univers de documents interconnectés en réaction à l'explosion documentaire qu'il observait. Bien qu'il n'ait pas lui-même inventé le terme "hypertexte", c'est une des premières instances de ce concept. Dans sa concrétisation technique, c'est dans les années 60 que le premier nœud de ce qui deviendra Internet a été mis en place par l'équipe de Tim Berners Lee.

On remarque que l'écart entre les moments clés se raccourcit plus le temps avance. En fait, cette observation peut se faire plus globalement lorsque l'on observe l'adoption des technologies. Ceci est évident si on compare le temps pris pour atteindre 50 millions d'auditeurs pour certaines technologies marquantes dans notre histoire : la radio a pris 38 ans, la télévision 13 ans, Internet 4 ans, le iPod 3 ans, et Facebook 2 ans (source : Did you know 3.0? 2012, https://www.youtube.com/watch?v=YmwwrGV_aiE; il est à noter que d'autres sources donnent des chiffres un peu différents, par exemple https://x.com/Guglielminetti/status/919245063967911937, mais une tendance similaire est observable). À titre d'exemple supplémentaire, certaines sources disent que ChatGPT a pris 2 mois pour atteindre 100 millions d'utilisateurs (source : After the ChatGPT moment: Measuring AI's Adoption, 2025, https://epochai.substack.com/p/after-the-chatgpt-moment-measuring)!

Si le rythme est essoufflant pour l'utilisateur et l'utilisatrice qui veut rester à jour, il l'est encore plus pour les organisations dont les activités sont étroitement liées à ces environnements numériques. Cela leur demande d'être de plus en plus agiles dans leur intégration des technologies et de s'habituer aux changements perpétuels, ce qui n'est pas toujours facile d'un point de vue humain et organisationnel.

L'histoire d'Internet et du Web est jalonnée de moments clés qui seront décrits dans les sections qui suivent.

Internet

D'entrée de jeu, il est important de bien comprendre que les termes Internet et Web ne sont pas synonymes! On retrouve parfois une certaine confusion entre les deux termes. Plus précisément, on peut définir Internet ainsi :

A huge computer network available to everyone with a personal computer and a means to connect to it. It is the actual physical network made up of wires, cables, and satellites as opposed to the web, which is the multimedia interface to resources available on the Internet.

(Source : O'Leary et al.[1], 2019, p. 367)

Le Web est ainsi une des sphères d'Internet, Internet étant un réseau plus large regroupant différentes sphères (Web, courriel, FTP, etc.).

Internet est né d'une initiative militaire américaine. Le premier nœud du réseau ARPANET (Advanced Research Project Agency Network) à l'origine d'Internet a été mis en place en 1969. Avant l'apparition du Web, les échanges sur Internet étaient uniquement textuels. Leiner et al. (1997)[2] précisent qu'une des clés du développement rapide d'Internet est le fait que la documentation, et plus particulièrement les spécifications et les protocoles, était accessible gratuitement et librement.

Web

Comme précisé dans la section précédente, le Web est une interface graphique à des contenus sur Internet :

Prior to the introduction of the web in 1992, the Internet was all text. The web made it possible to provide a multimedia interface that includes graphics, animations, sound, and video.

(Source : O'Leary et al.[1], 2019, p. 377)

Au cœur du Web se retrouve l'idée des documents interconnectés proposés en 1945 par Vannevar Bush. Dans son texte "As We May Think",[3] il propose l'idée d'une machine, nommée MEMEX, pour résoudre les problèmes liés à l'explosion documentaire. Cette dernière serait en effet en mesure de ranger et rendre accessible tous les documents en permettant :

La visualisation des documents sur microfilm sur un écran, documents pouvant être complétés par des images;

La localisation des documents;

L'inclusion de pistes associatives entre les documents.

Le néologisme "hypertexte" a été proposé par le philosophe et sociologue américain Theodore Nelson en 1965. Il est à l'origine du projet Xanadu dont l'objectif était de regrouper tous les documents de l'humanité. Ce système, accessible à tous, permettrait l'ajout de documents et la définition de liens entre ces derniers. Au départ, il s'agissait uniquement d'une conceptualisation sans implémentation. Depuis, des démonstrations ont vu le jour après bien des années, dont OpenXanadu en 2014[4].

Le premier logiciel hypertexte grand public, créé par Bill Atkinson, est HyperCard (Apple) en 1987, logiciel dont le développement s'est terminé en 1998. Il permettait de présenter des contenus multimédias sur des fiches virtuelles cartonnées, cartes qui pouvaient être liées entre elles par des boutons. Pour les curieux et les curieuses (ou les nostalgiques!), Internet Archive a mis en ligne en 2017 pour fêter les 30 ans d'HyperCard une collection de projets HyperCard.

Finalement l'application la plus connue du modèle hypertextuel, le Web, a été créée au CERN par l'équipe de Tim Berners-Lee en 1989. Il s'agit d'une version "allégée" des visions initialement proposées pour l'hypertexte entre autres par T. Nelson et V. Bush :

Absence de gestion des droits d'auteur;

Liens unidirectionnels se cassant lorsque la ressource disparaît;

Absence d'aperçu des ressources liées;

Absence de système d'annotation et de gestion de versions.

Le Web est passé par différentes phases (Web 1.0, Web 2.0 et Web 3.0) qui seront décrites dans les sections subséquentes.

Web 1.0 : Les premières années "statiques" du Web

La "première version du Web", le Web 1.0 en quelque sorte que certains désignent comme un Web de documents, correspond à un Web où un petit nombre d'internautes étaient des créateurs ou créatrices de contenus, cette création demandant en effet des compétences informatiques plus avancées. La majorité des internautes était ainsi des observateurs ou des observatrices pouvant chercher parmi les informations existantes et les consulter. Maignien (2014) le compare à une bibliothèque distribuée sans murs :

Le modèle documentaire est alors clairement celui d'une bibliothèque distribuée, sans murs, autrement appelée bibliothèque virtuelle ou numérique, mais où l'information n'est pas classée de façon hiérarchisée, dans un arbre, mais distribuée en graphe (il existe autant de relations non hiérarchisées que de liaisons possibles entre les documents ou des parties de ces documents).

(Source : Maignien, 2014[5], p. 78)

Web 2.0 : Le Web participatif

La génération suivante, le Web 2.0, est un phénomène à la fois technologique et social, ce que fait bien ressortir cette définition :

Web doté d'outils et de contenus interactifs qui permettent aux internautes de participer à la création de contenus Web, de partager de l'information en ligne et de communiquer entre eux.

(Source : Grand dictionnaire terminologique, 2018, https://vitrinelinguistique.oqlf.gouv.qc.ca/fiche-gdt/fiche/26519897/web-20)

Les mots-clés ici sont "participer", "création de contenus" et "partager". Certains services et certaines technologies phares sont associés au Web 2.0.

Services/Technologies | Définition | Exemples |

|---|---|---|

Blogues | « Site Web ou section de site Web généralement tenus par une seule personne, consacrés à une chronique personnelle ou à une thématique particulière présentées sous forme de billets ou d'articles. » (OQLF, 2018, https://vitrinelinguistique.oqlf.gouv.qc.ca/fiche-gdt/fiche/8370242/blogue) | Convergence AAQ : Le blogue de l'Association des archivistes du Québec |

Microblogues | « Blogue permettant de communiquer en temps réel au moyen de messages courts de 140 à 240 caractères, le plus souvent par l'intermédiaire d'une plateforme de microblogage, afin de partager de l'information avec une communauté d'internautes. » (OQLF, 2018, https://vitrinelinguistique.oqlf.gouv.qc.ca/fiche-gdt/fiche/26502311/microblogue) | |

Wikis | « Site Web collaboratif où chaque internaute visiteur peut participer à la rédaction du contenu. » (OQLF, 2011, https://vitrinelinguistique.oqlf.gouv.qc.ca/fiche-gdt/fiche/8362053/site-wiki) | |

Réseaux sociaux | Environnements où l'utilisateur ou l'utilisatrice se définit un profil (personnel ou professionnel) et réseaute avec d'autres utilisateurs et utilisatrices | Facebook (personnel) LinkedIn (professionnel) |

Plateformes de partage de ressources | Plateformes facilitant la composition de collections de ressources diverses et le partage de ces dernières | Flickr (photographies) YouTube (vidéos) Slideshare (présentations powerpoint) |

Fils de syndication | « Fil d'information consistant en un fichier XML, généré automatiquement, dont le contenu formaté, exploitable dynamiquement par d'autres sites Web, est récupérable par l'entremise d'un agrégateur qui permet de lire le nouveau contenu de ce fil répertorié, dès qu'il est disponible. » (OQLF, 2006, https://vitrinelinguistique.oqlf.gouv.qc.ca/fiche-gdt/fiche/8869144/fil-de-syndication) | Formats les plus connus : RSS et ATOM |

Folksonomies | « Système de classification collaborative et spontanée de contenus Internet, basé sur l'attribution de mots-clés librement choisis par des utilisateurs non spécialistes, qui favorise le partage de ressources et permet d'améliorer la recherche d'information. » (OQLF, 2006, https://vitrinelinguistique.oqlf.gouv.qc.ca/fiche-gdt/fiche/8351986/folksonomie) | Se retrouvent par exemple sur les plateformes de partage de ressources pour décrire les ressources ou sur les blogues pour décrire les billets |

L'expression Web 2.0 a été utilisée pour la première fois en 2004 par l'équipe d'O'Reilly Media qui, reprenant la métaphore des numéros de version pour les logiciels, voulait indiquer une version améliorée du Web. Certains lui préfèrent maintenant l'expression Web social qui est en effet une de ses principales facettes. À ses débuts, certains voyaient le Web 2.0 comme un effet de mode et, à l'autre extrême, d'autres le percevaient comme un changement de paradigme. Les chiffres, qui croissent d'année en année, montrent sans l'ombre d'un doute qu'il ne s'agissait pas d'un effet de mode.

Type | Plateforme | Chiffres | Source |

|---|---|---|---|

Partage de ressources | 2 milliards d'utilisateurs ou utilisatrices | https://www.statista.com/statistics/272014/global-social-networks-ranked-by-number-of-users/ (Février 2025) | |

YouTube | 20 millions de vidéo téléchargés quotidiennement en moyenne Plus de 100 pays en 80 langues | https://blog.youtube/press/ (2025-09-18) | |

Réseaux sociaux | Plus de 850 millions d'utilisateurs et utilisatrices Plus de 200 pays et territoires | https://about.linkedin.com/fr-fr (2025-09-18) | |

Plus de 3 milliards d'utilisateurs et utilisatrices Plus de 510 000 commentaires rédigés en une seule minute | https://digitiz.fr/statistiques-facebook/ (2025-09-18) | ||

Rédaction collaborative | Wikipédia | 65 516 514 articles 2 709 830 articles en français 343 langues actives | https://meta.wikimedia.org/wiki/List_of_Wikipedias et https://wikistats.wmcloud.org/display.php?t=wp (2025-09-18) |

Micro-blogosphère | X | 586 millions d'utilisateurs et utilisatrices | https://www.statista.com/statistics/272014/global-social-networks-ranked-by-number-of-users/ (Février 2025) |

Bluesky | 38 millions d'utilisateurs et utilisatrices | https://www.statista.com/statistics/1536616/global-bluesky-users/ (Août 2025) |

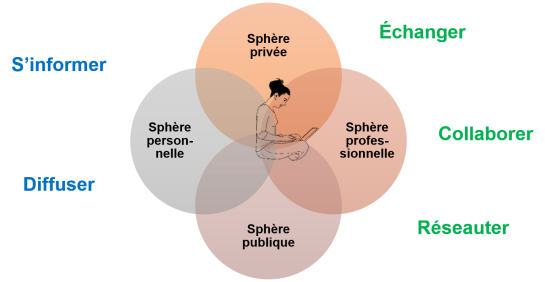

Si on peut hésiter à parler d'une révolution, il s'agit très clairement d'une évolution tant des technologies que de leur utilisation. L'internaute qui le désire a maintenant à sa portée des technologies qui lui permettent de passer, s'il ou elle le désire, d'un rôle uniquement d'observation à un rôle de création, que ce soit dans ses activités personnelles ou professionnelles. Les internautes utilisent le Web 2.0 sur une base personnelle, mais aussi professionnelle, dans un cadre public ou privé, que ce soit pour informer et s'informer (à la « Web 1.0 »), mais aussi pour collaborer, réseauter ou échanger dans le cadre de leurs activités.

Dans l'univers du Web 2.0, on observe que les sphères publique et privée, personnelle et professionnelle deviennent perméables, leurs frontières étant plus floues. Par exemple, certains blogueurs mélangent parfois anecdotes personnelles et réflexions liées à leur travail sur leurs blogues. Le caractère privé de certaines formes d'expression, comme les journaux intimes, s'ouvre à la sphère publique, par exemple sur les blogues et les réseaux sociaux.

Adoption du Web 2.0 au Québec

L'utilisation faite des technologies du Web 2.0 est aussi tributaire du contexte des internautes. Une fracture numérique existe toujours pour certaines régions ou certains pays ayant un accès limité à ces plateformes pour des raisons économiques ou sociales. Au Québec, la population est globalement branchée et active sur les réseaux sociaux. En 2024, 92 % des adultes québécois ayant participé à l'enquête NETendances avaient utilisé Internet au cours des 3 derniers mois (Académie de la transformation numérique. 2024. NETendances 2024 : Portrait numérique des foyers québécois. Volume 15, no 5. https://transformation-numerique.ulaval.ca/wp-content/uploads/2025/02/netendances24-intelligence-artificielle-generative-et-donnees-personnelles.pdf).

Les jeunes ne sont pas en reste! Une grande majorité des 13 à 17 ans, selon l'enquête NETendances, possèdent un profil sur un réseau social (81 %), TikTok étant le plus populaire (67 %), suivi par Instagram (59 %) et Snapchat (52 %) (Académie de la transformation numérique. 2024. NETendances 2024 : Famille numérique. Volume 15, no 6. https://transformation-numerique.ulaval.ca/wp-content/uploads/2025/03/netendances24-famille-numerique.pdf). Selon cette même étude, une des activités les plus pratiquées par les enfants de 6 à 17 ans est l'écoute de vidéos par exemple sur YouTube ou Tiktok (73 %).

On retrouve plusieurs initiatives d'exploitation des plateformes 2.0 entre autres au sein des institutions culturelles québécoises.

Initiatives | But(s) |

|---|---|

Projets Wiki de BAnQ | « Ces projets visent à mettre en valeur les fonds et les collections de BAnQ, à rendre disponibles aux wikimédiens les ressources numérisées de l'institution et à contribuer à l'enrichissement des articles de Wikipédia (et ses projets frères) concernant le Québec, le Canada français et, plus largement, l'Amérique française. » |

Projets Wiki de la Cinémathèque québécoise https://fr.wikipedia.org/wiki/Wikipédia:Cinémathèque_québécoise | « La Cinémathèque québécoise s'investit dans la production et la diffusion de connaissances libres sur le cinéma québécois. Depuis septembre 2017, nous organisons notamment des activités citoyennes dans le but d'enrichir les projets Wikimédia dans ce domaine. » |

Café des savoirs libres | « Le Café des savoirs libres est un collectif montréalais de bibliothécaires, enseignants, chercheurs et autres passionné(e)s qui organise des rencontres de partage, des projets et des événements autour des savoirs libres et des communs numériques. » |

(Source d'inspiration : compte-rendu de la conférence-midi du 21 septembre 2017 sur la culture ouverte et le savoir libre par @bibliomancienne (Marie D. Martel) https://bibliomancienne.com/2017/09/22/culture-ouverte-et-savoir-libre-a-lebsi-sqil-copibecpasenmonnom/)

Web 3.0 : Le Web sémantique

Le World Wide Web Consortium (W3C)définit le Web sémantique ainsi :

The Semantic Web provides a common framework that allows data to be shared and reused across application, enterprise, and community boundaries. It is a collaborative effort led by W3C with participation from a large number of researchers and industrial partners.

L'idée centrale de ce qu'ils identifient comme un Web de données est celle d'un Web où les documents sont « enrichis » de manière à les rendre compréhensibles non seulement aux humains, mais aussi aux machines pour en faciliter la réutilisation. Cet enrichissement se fait à l'aide de métadonnées[7] permettant de décrire différents aspects des documents (par exemple, l'auteur, la date de création).

En fait, les folksonomies du Web 2.0 représentent une certaine couche « sémantique » ajoutée aux ressources et illustre le potentiel du « Web sémantique » en ce qu'elles permettent la création de nouvelles connaissances; « certaine » car c'est souvent une sémantique plus personnelle que collective qu'on y retrouve comme les étiquettes que l'on met à des photos sur Flickr par exemple. À un certain moment, parmi les étiquettes les plus populaires sur Flickr se retrouvait le mot "me" comme plusieurs utilisateurs l'employaient pour les photos où ils se retrouvaient!

Les applications composites – ou les mashups – que l'on retrouve sur le Web 2.0 démontrent l'intérêt du croisement de diverses données. Pensons par exemple à la possibilité d'explorer les photos déposées sur Flickr à l'aide d'une carte (https://www.flickr.com/map). La carte créée est le résultat du croisement des étiquettes géographiques apposées par les utilisateurs de Flickr à leurs photos avec une carte.

Cette idée d'ajouter aux documents du Web une couche sémantique pour en faciliter le partage et la réutilisation est attribuée à Tim Berners-Lee. Une des premières mentions de cette idée lui est attribuée lors de l'International World Wide Web Conference en 1994. Le Web sémantique est ainsi une extension du Web que l'on connaît par l'ajout de cette couche sémantique et le développement de technologies permettant de l'exploiter. Différents standards y sont rattachés que Bermès et coll.[8] (2013, p. 28) décrivent ainsi :

Ainsi, le Web sémantique a pour objet de fournir des standards qui vont rendre possible ce Web plus intelligent et plus efficace. Ces standards incluent le modèle RDF (*), des outils comme RDFS (*) (RDF Schema) et OWL (*) (Web Ontology Language) pour décrire la sémantique et la logique des données, et aussi des standards pour manipuler et traiter les données, comme SPARQL (*), le langage et protocole de requête de RDF.

Dans leur ouvrage, ces auteurs s'intéressent au Web sémantique en bibliothèque et espèrent réussir par cet ouvrage à "mobiliser vos [bibliothécaires] compétences d'analyse de l'information et de traitement des données pour vous [bibliothécaires] montrer comment elles peuvent être mises en valeur dans le nouvel environnement apporté par le Web sémantique." (Bermès et al., 2013, p. 13). Comme Da Sylva[9] le précise (2017, p. 28), Bermès et al. dans leur ouvrage reconnaissent le rôle des bibliothèques dans le Web sémantique, rôle en continuité avec leurs missions et leurs activités traditionnelles. Il importe ainsi comme professionnelles et professionnels de l'information d'en connaître les bases et tout particulièrement les types de données qu'on y retrouve, soit les données ouvertes liées décrites plus loin dans les notes de cours.

Exemple : Google Knowledge Graph

Un exemple du Web sémantique que l'on croise fréquemment dans nos recherches sur le Web est le Google Knowledge Graph. En effet, on voit apparaître lors de certaines recherches dans le moteur de recherche Google un encart à la droite de la liste des résultats retournés qui présente des informations souvent factuelles en lien avec la recherche. C'est le cas par exemple si vous faites une recherche sur une personnalité connue ou un pays. Cet encart est produit par la mise en relation de plusieurs jeux de données distincts en lien avec l'objet de votre recherche. C'est un exemple du potentiel du Web sémantique qui permet, par la couche sémantique ajoutée à certaines données, de générer de nouvelles données (les encarts de Google Knowledge Graph). Plus d'informations sur cette fonctionnalité sont disponibles sur le blogue de Google à l'URL https://googleblog.blogspot.com/2012/05/introducing-knowledge-graph-things-not.html.

Intelligence artificielle générative

Si l'intelligence artificielle générative (IAg) est un phénomène relativement récent pour le grand public, l'origine de l'intelligence artificielle (IA)remonte quant à elle à plusieurs décennies. Voici quelques jalons des développements en lien avec l'IA à titre d'exemple :

Le premier article fondateur sur les neurones formelles, qui a servi de base théorique à l'intelligence artificielle, a été publié par Warren McCulloch et Walter Pitts en 1943 ( WIKIPEDIA - Réseau de neurones artificiels 2025[10]).

L'intelligence artificielle est en fait officiellement devenue une discipline scientifique en 1956 lors d'une conférence à Dartmouth ( WIKIPEDIA - Conférence de Dartmouth 2025[11]).

ELIZA, Le premier programme capable de simuler une conversation humaine, précurseur de l'intelligence artificielle générative telle qu'on la connaît actuellement, a été présenté par Joseph Weinbaum en 1965 ( WIKIPEDIA - ELIZA 2025[12]).

C'est le lancement de ChatGPT, en novembre 2022, qui a rendu l'IAg accessible au grand public.

L’IAg se définit comme :

« AI that can create new content such as text, images, or audio by learning patterns from existing data and generating novel outputs that reflect those patterns. » ( BENGIO et al. 2025[13], p. 222)

L’IAg repose sur des modèles avancés comme les grands modèles de langage (Large Language Models - LLMs) qui vont générer des contenus à partir d’ensembles de données massives en y identifiant des structures probables. Ces nouveaux outils ouvrent une multitude de possibilités pour soutenir les internautes dans différentes tâches impliquant entre autres la création, la modification, l’analyse de contenus diversifiés, pour un gain en efficacité étonnant. Mentionnons, par exemple :

Création de texte : ChatGPT, Gemini et NotebookLM

Création d’images : DALL-E et Midjourney

Création de vidéos : Synthesia

L’IAg fait partie maintenant de la vie de nombreuses personnes, parfois de manière consciente, en utilisant certaines IAgs telles que ChatGPT, DALL-E ou Scite. D’autres fois l’usage n’est pas conscient, comme l’IAg s’intègre de plus en plus de manière transparente dans différents logiciels d’application. C’est le cas, par exemple, de la dernière version du correcteur Antidote qui offre des fonctionnalités de reformulation de phrase basées sur l’IAg. Ces outils ouvrent la porte à des usages variés pour, par exemple, la création de contenus (textes, images, vidéos, etc.), la synthèse de textes ou la recherche documentaire.

La littérature fait état de l’intégration de l’IAg dans différents secteurs, comme en santé, dans le domaine du marketing ou de l’éducation. Des recherches portent entre autres sur l’utilisation de l’IAg dans le domaine de l’enseignement supérieur et présentent des usages tant des personnes étudiantes, par exemple pour soutenir la recherche documentaire ou le processus d’idéation, que des personnes enseignantes qui peuvent s’en servir, notamment en soutien à la création d’activité pédagogique.

Malgré tous les avantages de l’IAg, il y a certains risques à garder à l’esprit que l’on peut regrouper en trois catégories ( BENGIO et al. 2025[13]) qui peuvent aussi s’appliquer à l’IAg :

Risques liés à une utilisation malicieuse

Risques liés à un mauvais fonctionnement

Risques systémiques

Risques liés à une utilisation malicieuse

L’IAg peut être exploitée à de fins malicieuses comme, par exemple, pour générer de fausses informations pour frauder des gens ou les manipuler. Les hypertrucages qu’elle permet de créer peuvent en effet induire en erreur tant ils peuvent être réalistes.

Risques liés à un mauvais fonctionnement

L’IAg peut, de manière non intentionnelle, générer du biais provenant des corpus de connaissances utilisés. Elle peut aussi produire des informations qui sont fausses. Ces outils ne comprennent en effet pas réellement le contenu généré et les requêtes. Leur fonctionnement se base sur le calcul de ce qui est le plus probable en fonction des requêtes par rapport aux bases de connaissance exploitées. Ces outils sont ainsi faillibles et peuvent se tromper ( VANGRUNDERBEECK et al. 2024[14], p. 5)! Il faut donc demeurer très critique dans leur utilisation par rapport aux contenus générés. L’IAg est une source d’information parmi d’autres dont il faut valider l’information, comme on le ferait avec d’autres sources. Nous reviendrons dans un prochain module sur la notion de la fiabilité de l’information. L’usage efficace de l’IAg repose aussi sur le développement d’une littératie de l’intelligence artificielle qui, en sus des questions de son usage éthique et responsable, comprend une bonne connaissance de son mode de fonctionnement ainsi que de l’« art » de la rédactique[15] (prompt engineering).

Risques systémiques

Le déploiement rapide et à grande échelle de l’IAg provoque des changements à plusieurs niveaux. Par exemple, certains secteurs du marché de l’emploi peuvent être bousculés du fait de l’automatisation qu’elle rend possible de certaines tâches.

La question des droits d’auteur et de la propriété intellectuelle est aussi un enjeu important par rapport à l’utilisation de l’IAg. D’une part, l’éthique de certains outils d’IAG est remise en question comme ils utilisent pour s’entraîner des données sans s’assurer d’avoir les droits pour le faire. En fait, les données que l’on injecte soi-même lorsque l’on utilise une IAg peuvent être exploitées à des fins d’entraînement par cette dernière; il ne faut donc pas y déposer des informations personnelles ou confidentielles. D’autre part, il est aussi légitime de se demander à qui appartiennent les droits des contenus générés par l’IAG et si l’usage de l’IAG est accepté dans certains contextes. Dans le cadre des études universitaires, par exemple, il est important que les personnes étudiantes s’assurent qu’elles peuvent utiliser l’IAg dans leurs travaux afin de ne pas que leur travail soit reconnu comme du plagiat.

La problématique environnementale fait aussi partie des risques systémiques de l’IAg. Bien que l’IAg peut être utilisée pour participer à trouver des solutions à des enjeux environnementaux, elle est aussi une grande consommatrice d’énergie, d’une part, et d’eau, d’autre part. Sa consommation vient notamment des centres de données utilisés pour entreposer et traiter les données nécessaires à l’IAg. Un centre de données peut consommer autant d’énergie qu’une petite ville, certains des plus grands centres situés en Virginie, par exemple, pouvant consommer l’équivalent de 25 000 résidences ( RADIO-CANADA INFO (réalisateur) 2025[16]). Le nombre total de centres de données exploités pour l’intelligence artificielle générative n’est pas connu, il s’agit d’un secret bien gardé! On estimait par exemple à la fin 2024 qu’il y avait 239 centres de données au Canada pour tous types d’usage (et non uniquement pour l’intelligence artificielle générative) ( GOUVERNEMENT DU CANADA 2024[17]). Ces centres de données consomment de l’eau directement pour le refroidissement de leurs ordinateurs ainsi qu’indirectement lors de la production de l’énergie consommée. Cette consommation n’est pas négligeable : certaines études montrent qu’une interaction avec ChatGPT peut consommer 2 litres d’eau ( RADIO-CANADA INFO (réalisateur) 2025[16]) et certains estiment qu’il y a plus d’un milliard de requêtes envoyées à ChatGPT sur une base quotidienne. Une utilisation responsable de ces outils tient pour acquise une conscientisation sur ces impacts environnementaux; il faut se demander : « Est-ce bien le bon outil? ».